Découvrez cette nouvelle manière de concevoir la consommation de ressources informatiques qui consiste à confier aux équipements réseau le soin de stocker et traiter les données.

1. Qu’est-ce que le fog computing ?

Egalement appelé fog networking ou fogging, le fog computing renvoie à une infrastructure matérielle et applicative distribuée, taillée pour stocker et traiter les données issues des objets connectés. Au lieu de centraliser dans le cloud les informations produites par les capteurs, l’idée à travers cet environnement est de faire appel aux équipements situés à la périphérie du réseau (routeurs, passerelles, commutateurs, appareils mobiles…) pour réaliser les traitements. En créant cette surcouche intermédiaire au plus près de la production des données, l’objectif est in fine d’optimiser les délais de réponse des applications.

Le fog computing est considéré comme une extension locale du cloud. Par contraste avec le cloud, ou nuage, qui se forme dans le ciel (traduisant l’idée d’une informatique distante), le terme anglais fog (brouillard en français) se forme au dessus du sol. L’expression fog computing renvoie ainsi à la notion d’une informatique plus proche du monde physique, des terminaux et de l’IoT. Un ingénieur de chez Cisco serait à l’origine du concept.

2. Quelle est la promesse du fog computing ?

Face à l’explosion des volumes de données issus des objets connectés, les infrastructures actuelles de cloud, très centralisées, pourraient atteindre leur limite. Les capacités des réseaux et des datacenters existants risquent en effet la saturation, ce qui ferait exploser les temps de latence et rendrait le traitement des données incompatible avec les besoins d’analyse en temps réel. Avec le cloud, les serveurs capables de traiter les données sont distants et leur temps de réponse dépend de facteurs que l’utilisateur ne peut pas contrôler : charge de travail des serveurs, encombrement du réseau… Le fog computing a pour but d’apporter une réponse à cette problématique. Il réduit le chemin à parcourir entre l’appareil qui produit les données et l’équipement qui les traite, et la nécessité de faire transiter les données vers les serveurs.

3. Qu’est-ce que le consortium OpenFog ?

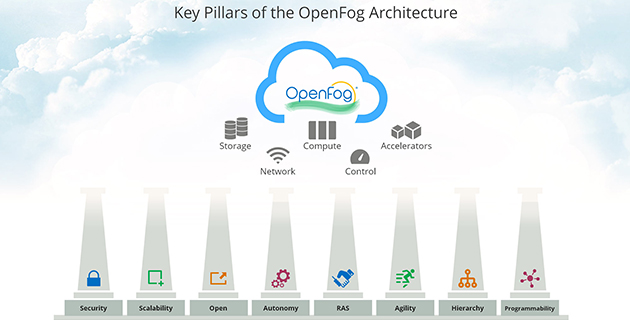

Créé en 2015 par ARM, Cisco, Dell, Intel et Microsoft notamment, ce consortium a pour but de fédérer les entreprises impliquées dans le fog computing autour de la définition de protocoles réseau et standards technologiques qui permettront de normaliser le marché. L’enjeu est de définir une architecture distribuée qui se veut « dimensionable » (scalable) pour s’adapter à la montée en puissance de l’IoT. Mais aussi ouverte pour permettre à chaque acteur impliqué de venir y greffer ses produits. Son caractère standard permettant en outre de rassurer les clients potentiels sur la pérennité de leurs investissements.

4. Comment fonctionne le fog computing ?

L’OpenFog a défini une infrastructure pour mettre en œuvre une solution de FaaS (Fog as a Service). Celle-ci se décline en plusieurs couches calquées sur la logique d’empilement du cloud (IaaS, PaaS et SaaS). Une architecture à laquelle s’ajoutent des éléments spécifiques au fog computing : des services d’interconnexion réseau, de collecte de données à partir des objets connectés, ou encore des applications de traitement plus spécifiques. Le principe de fonctionnement est ainsi le même que celui du cloud avec quelques particularités.

5. Le fog computing peut-il remplacer le cloud ?

Le fog computing n’est pas destiné à remplacer le cloud. C’est une couche applicative et matérielle complémentaire. Elle permet de répondre à des besoins applicatifs précis liés au traitement en temps réel. Certains cas d’usage, comme les véhicules autonomes ou les compteurs intelligents avec prise de décision immédiate, nécessitent des traitements instantanés qui pourront être pris en charge par cette architecture. D’autres applications sont plus adaptées au cloud qui garde toute sa pertinence dans beaucoup de type de traitements de données, par exemple en matière d’Analytics.

6. Le fog computing est-il un standard ?

Pour l’heure, il n’existe pas de standard à proprement parler dans ce domaine. Le consortium OpenFog est trop récent pour avoir eu le temps de définir des standards. Il préconise toutefois une architecture de référence : l’OpenFog Reference Architecture (voir l’illustration ci-dessous). D’après ses concepteurs, il s’agit de la « première étape en vue de la création de normes pour permettre l’interopérabilité dans l’IoT, la 5G, l’intelligence artificielle, l’Internet tactile, la réalité virtuelle et d’autres applications complexes de données et réseaux ». Bien qu’il regroupe de grands noms de l’informatique BtoB, le consortium ne fédère pas tous les géants informatiques : HPE et IBM n’en font pas partie par exemple.

7. Quelle est la différence entre fog computing et edge computing ?

L’edge computing se réfère à tous les équipements IT d' »extrémité », c’est-à-dire installés au plus près des utilisateurs et sources de données. Ces équipements informatiques et réseau peuvent faire partie d’une infrastructure de fog computing. Ils ne se limitent pas seulement aux équipements IT conventionnels. Les objets connectés capables de stocker et de traiter les données en local sont aussi considérés comme faisant partie d’une infrastructure d’edge computing.

Lire l’article sur http://www.journaldunet.com/solutions/cloud-computing/1193318-comprendre-le-fog-computing-en-sept-questions